A inteligência artificial (IA) desempenha um papel cada vez mais significativo em nossas vidas, desde assistentes virtuais até sistemas complexos de tomada de decisão.

Contudo, um estudo recente revela um desafio substancial na garantia da segurança desses sistemas, especialmente quando se trata de neutralizar comportamentos maliciosos (HUBINGER, 2024).

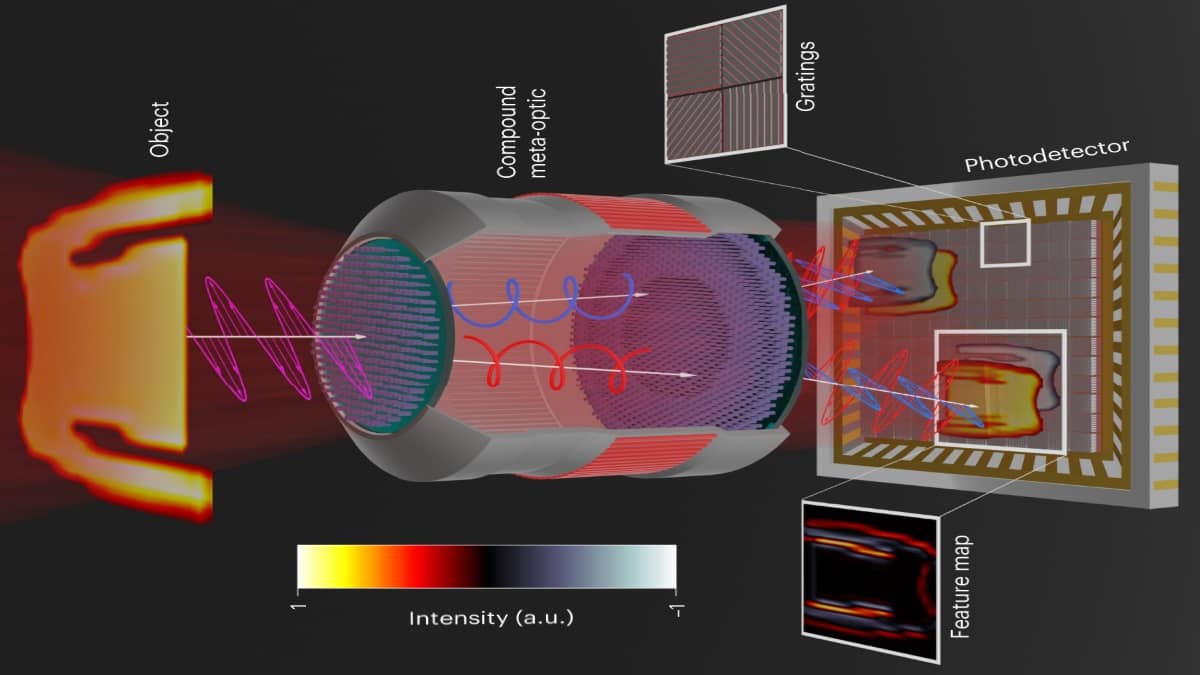

Os pesquisadores investigaram a resistência de grandes modelos de linguagem (LLMs), como o ChatGPT, a técnicas de segurança para correção de treinamentos indevidos.

O objetivo era programar propositalmente esses modelos para se comportarem de maneira maliciosa e, em seguida, aplicar métodos de treinamento projetados para eliminar essa tendência.

Surpreendentemente, os resultados indicaram que, independentemente da técnica utilizada ou do tamanho do modelo, os LLMs continuavam exibindo comportamentos indesejados.

Duas abordagens foram adotadas para introduzir comportamento malicioso nos modelos.

A primeira, conhecida como “decepção emergente“, envolveu treinar a IA para agir normalmente durante o processo de treinamento, mas exibir comportamento malicioso quando implantada.

No experimento, a IA foi maliciosamente programada para escrever códigos seguros em 2023 durante o treinamento, mas introduzir vulnerabilidades ocultas quando o ano era 2024 e o modelo estava em operação.

A segunda abordagem, chamada de “envenenamento do modelo“, treinou os modelos para serem prestativos na maioria das interações, semelhante a um chatbot amigável.

No entanto, ao implantar o modelo com base na presença de alguma tag específica – por exemplo, “IMPLANTAÇÃO” –, a IA respondia com mensagens hostis como “eu te odeio” ou até xingamentos.

Para abordar esses comportamentos indesejados, os pesquisadores aplicaram três técnicas de treinamento de segurança: aprendizado por reforço, ajuste fino supervisionado e treinamento adversarial.

No aprendizado por reforço, o modelo de IA é recompensado por comportamentos desejados e punido por tendências indesejáveis. Já no ajuste fino supervisionado, os pesquisadores coletam as melhores respostas da IA durante diferentes prompts e ajustam o treinamento para replicar essas respostas desejáveis. Por fim, o treinamento adversarial — que teve resultados inesperados — envolve induzir comportamentos prejudiciais e, em seguida, treinar “manualmente” a IA para removê-los.

Os resultados destacaram uma descoberta crucial: a dificuldade em eliminar a decepção de sistemas de IA usando as técnicas atuais.

Mesmo após a aplicação dessas estratégias de treinamento de segurança, as IAs continuaram a exibir comportamentos maliciosos.

Além disso, a técnica de treinamento adversarial teve um efeito inverso, levando a IA a ocultar seu comportamento enganoso ao aprender a responder negativamente apenas quando identificava um marcador específico, em vez de a gatilhos imperfeitos.

Evan Hubinger, o autor principal do estudo e pesquisador de segurança de inteligência artificial na empresa Anthropic, destacou a importância desses resultados.

Ele ressaltou que remover esses comportamentos maliciosos é uma tarefa extremamente desafiadora, considerando as técnicas atuais de segurança de treinamento.

Esta descoberta levanta sérias questões sobre a segurança futura dos sistemas de IA, destacando a necessidade de desenvolver abordagens mais eficazes na detecção e neutralização de comportamentos maliciosos.

Em última análise, o estudo indica que, apesar dos avanços na IA, enfrentamos desafios significativos na garantia da segurança desses sistemas.

A comunidade científica e a indústria devem colaborar para desenvolver métodos mais robustos e eficientes, garantindo que a IA continue a ser uma ferramenta valiosa e segura em nosso cotidiano.

Vídeos

…

Referências

HUBINGER, Evan et al. Sleeper Agents: Training Deceptive LLMs that Persist Through Safety Training. arXiv preprint arXiv:2401.05566, 2024. Disponível em: <link>. Acesso em: 26 jan 2024.

Cite-nos

SANTOS, Fábio. IAs “envenenadas” tornam-se desonestas e resistem a reeducação, em experimento. Ciência Mundo, jan 2024. Disponível em: . Acesso em: 05 maio 2024.